ChatGPT, der KI-gestützte Chatbot, hat sich seit seiner Einführung im November 2022 zur am schnellsten wachsenden Internetanwendung der Geschichte entwickelt. In nur zwei Monaten wurden 100 Millionen aktive Nutzer erreicht.

Nach Angaben des Technologieüberwachungsunternehmens Sensor Town dauerte es 2,5 Jahre, bis Instagram diese Nutzerzahl erreichte.

Mit dem Aufkommen von ChatGPT begann eine hitzige Debatte über die KI-Sicherheit.

ChatGPT, entwickelt vom Unternehmen Open AI mit finanzieller Unterstützung von Microsoft, hat heftige Spekulationen über die Auswirkungen künstlicher Intelligenz auf die Zukunft der Menschheit ausgelöst.

Dutzende Experten unterstützten die auf der Website des AI Security Center veröffentlichte Aussage, dass „die Verringerung des Risikos des Aussterbens durch KI eine globale Priorität sein sollte, mit großen Risiken wie Pandemien und Atomkrieg.“

Einige Experten halten die Bedenken jedoch für übertrieben.

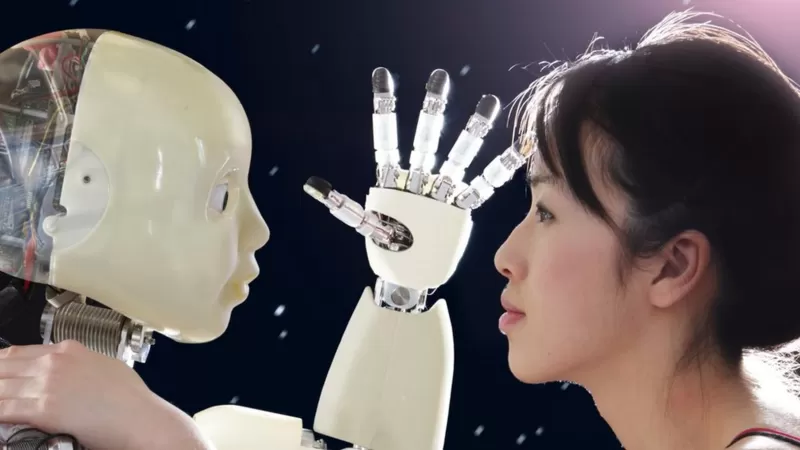

Menschen nachahmen

Essays, Gedichte, Witze, Computercodes, Texte, Diagramme, Fotos und Kunstwerke, die durch Anwendungen der künstlichen Intelligenz wie ChatGPT, DALL-E, Bard und AlphaCode erstellt wurden, können sich nicht von von Menschenhand geschaffenen unterscheiden.

Studenten nutzen diese Apps, um ihre Hausaufgaben zu machen, und Politiker, um ihre Reden zu schreiben. Der letzte dieser Politiker war Jake Auchincloss, Mitglied der Demokratischen Partei im US-Repräsentantenhaus.

Der Technologieriese IBM hat angekündigt, die 7.800 Mitarbeiter, die für Aufgaben zuständig sind, die durch KI erledigt werden können, nicht zu ersetzen.

Mit dem Fortschritt der KI wächst auch ihre Fähigkeit, das zu übernehmen, was Menschen tun.

Wenn Ihnen all diese Veränderungen zu viel sind, bereiten Sie sich darauf vor:

Wir befinden uns erst in Phase eins der KI und zwei weitere Phasen sind auf dem Weg, von denen einige Wissenschaftler befürchten, dass sie die menschliche Existenz bedrohen könnten.

Hier sind die drei Phasen der KI.

1. Schmale künstliche Intelligenz (ANI)

Narrow Artificial Intelligence (ANI), auch Dar IA genannt, konzentriert sich auf eine einzelne Aufgabe und führt bestimmte Aufgaben aus.

Normalerweise lernt er viele Daten aus dem Internet, aber nur in einem angemessenen Bereich, in dem er programmiert ist.

Ein Beispiel hierfür sind Schachprogramme. Sie können den Weltmeister schlagen, aber eine andere Aufgabe können sie nicht erfüllen.

Eine schmale KI kann Menschen schlagen, aber nur in einem bestimmten Bereich.

Smartphones sind voll von Apps, die diese Technologie nutzen. Von GPS-Karten bis hin zu Musik- und Videoprogrammen, die Ihren Stil kennen und Ratschläge geben.

Auch fahrerlose Fahrzeuge und komplexere Systeme wie ChatGPT sind verschiedene Formen der Narrow AI. Sie können nicht außerhalb einer Reihe von Rollen agieren, das heißt, sie können keine Entscheidungen selbst treffen.

Einige Experten glauben jedoch, dass Systeme, die so programmiert sind, dass sie automatisch lernen, wie ChatGPT und AutoGPT, die nächste Entwicklungsstufe erreichen können.

2. Künstliche allgemeine Intelligenz (AGI)

Künstliche allgemeine Intelligenz wird durch eine Maschine erreicht, die jede intellektuelle Mission erfüllt, die ein Mensch erfüllen kann.

Künstliche allgemeine Intelligenz, bei der eine Maschine über die gleichen intellektuellen Fähigkeiten wie ein Mensch verfügt.

Aufruf zu „6 Monaten mittelfristig“

Im März 2023 forderten mehr als 1.000 Technologen „alle KI-Labore auf, sofort eine sechsmonatige Fortbildung für KI auf allen Systemen anzubieten, die stärker als GPT-4, die neueste Version von ChatGPT“, sind.

„KI-Systeme, die mit Menschen konkurrieren können, stellen enorme Risiken für die Gesellschaft und die Menschheit dar“, schrieben andere Technologen, darunter Steve Wozniak, Mitbegründer von Apple, und Elon Musk, Besitzer von Tesla und Space X.

Elon Musk war einer der Gründer von Open AI, bevor er zurücktrat, nachdem er Probleme mit dem Vorstandsteam des Unternehmens hatte.

In dem von der gemeinnützigen Organisation The Future of Life Institute veröffentlichten Brief sagten Experten: „Wenn Unternehmen ihre Projekte nicht sofort stoppen, sollten die Regierungen eingreifen und ein Moratorium verhängen“, damit Sicherheitsmaßnahmen entworfen und umgesetzt werden können.

„So dumm wie klug“

Auch Carissa Veliz vom Ethics Institute at AI der Universität Oxford unterzeichnete den Brief. Später erklärte er jedoch, dass die Erklärung des Center for AI Security, in der von der Auslöschung der Menschheit gesprochen wurde, zu weit ging und entschied sich daher, sie nicht zu unterzeichnen.

„Die Art von KI, die wir gerade entwickeln, ist ebenso dumm wie intelligent. Wer ChatGPT oder andere ausprobiert, wird feststellen, dass es einige sehr, sehr wertvolle Mängel aufweist“, sagte Carissa Veliz gegenüber der BBC.

Veliz äußerte auch Befürchtungen, dass KI massive Mengen an Desinformation erzeugen könnte, und fügte hinzu: „Ich mache mir darüber mehr Sorgen, da die amerikanischen Präsidentschaftswahlen im Jahr 2024 näher rückten und Twitter und andere Ethik- und Sicherheitsgruppen für KI feuern.“

Die US-Regierung erkennt mögliche Bedrohungen an.

„KI ist heute die leistungsfähigste Technologie, aber um die Chancen, die sie bietet, zu nutzen, müssen wir zunächst ihre Risiken reduzieren“, sagte das Weiße Haus in einer schriftlichen Erklärung vom 4. Mai.

Sam Altman, CEO von Open AI, sprach im Kongress und beantwortete Fragen zu ChatGPT.

Sam Altman, CEO von Open AI und Erfinder von ChatGPT, gab dem Kongress einen Schub für die staatliche Aufsicht und Regelsetzung von KI.

Altman sagte in seinen Worten vor dem Senat: „Da die KI immer stärker wird, ist es für die Branche wertvoll, von der Regierung reguliert zu werden.“

Carlos Ignacio Gutierrez, Politikforscher am Future of Life Institute, sagte gegenüber der BBC, dass die größte Herausforderung durch KI darin bestehe, dass es kein Expertengremium gebe, das darüber entscheide, wie Regeln festgelegt werden, wie etwa das Zwischenstaatliche Gremium für Klimaänderungen (IPCC).

Das bringt uns zur dritten und letzten Phase der KI.

3. Brillante künstliche Intelligenz (ASI)

Wenn wir der Theorie zufolge die zweite Ebene (AGI) erreichen, springen wir zur letzten Ebene „Super Künstliche Intelligenz“ (ASI). Dies wird geschehen, wenn die künstliche Intelligenz größer ist als die menschliche Intelligenz.

Der Philosoph und KI-Experte Nick Bostrom von der Universität Oxford definiert brillante Intelligenz als „eine Intelligenz, die das menschliche Gehirn in fast allen Bereichen, einschließlich wissenschaftlicher Kreativität, allgemeiner Weisheit und sozialen Fähigkeiten, bei weitem übertrifft.“

Gutierrez erklärt: „Menschen müssen lange studieren, um Ingenieur, Krankenschwester oder Anwalt zu werden. Das Problem bei AGI ist, dass es sich immer verbessert, auch in Zeiten, in denen wir es nicht können.“

Science-Fiction

Arnold Schwarzenegger hat in Kinos wie dem Terminator gearbeitet, in denen Menschen mit künstlicher Intelligenz zu kämpfen haben.

Arvind Narayanan, ein Computeringenieur von der Princeton University, sagte zuvor gegenüber der BBC, dass Katastrophenszenarien ähnlich der Science-Fiction nicht gerechtfertigt seien:

„Die derzeitige KI ist bei weitem nicht in der Lage, diese Risiken Wirklichkeit werden zu lassen. Dies hat zur Folge, dass die Aufmerksamkeit von den kurzfristigen Schäden der KI abgelenkt wird.“

Will Smith spielte im Film „I, Robot“ aus dem Jahr 2004 einen technikfeindlichen Mordkommissar.

Es gibt viele Diskussionen darüber, ob Maschinen wirklich über eine Intelligenz verfügen können, die so umfassend ist wie die eines Menschen, insbesondere wenn es um emotionale Intelligenz geht. Dies ist eines der Dinge, die diejenigen am meisten beunruhigen, die glauben, dass wir kurz davor stehen, AGI zu erreichen.

Hollywood und KI: Im Film „2001: Odyssee im Weltraum“ von 1968 kontrollierte der Raumschiffcomputer HAL die Systeme des Raumschiffs und quälte die Besatzung.

Kürzlich warnte Geoffrey Hinton, der den Spitznamen „Vater der künstlichen Intelligenz“ trägt und einer der Pioniere darin ist, Maschinen beizubringen, aus Erfahrungen zu lernen, dass wir kurz vor einem Wendepunkt stehen.

„Vater der KI“ Geoffrey Hinton gibt eine Gefahrenwarnung heraus, als er von Google zurücktritt.

„Soweit ich weiß, sind Maschinen im Moment noch nicht schlauer als wir, aber das könnte schon bald der Fall sein“, sagte Hinton, 75, ein frisch pensionierter Google-Mitarbeiter.

In seinem Brief an die New York Times, in dem er seinen Abschied von Google ankündigte, sagte Hinton, er bereue seinen Job, weil er „fürchtete, dass schlechte Schauspieler KI für schreckliche Dinge nutzen würden“.

Hinton nannte der BBC dieses „Albtraumszenario“ als Beispiel

„Stellen Sie sich zum Beispiel vor, ein mieser Schauspieler wie der russische Präsident Wladimir Putin hätte Robotern die Fähigkeit gegeben, ihre eigene Absicht zu erschaffen. Maschinen können schließlich eine Unterabsicht erzeugen: ‚Brauche mehr Macht‘, und das wird zu einer ‚existenziellen Bedrohung‘.“

Aber Hinton merkte an, dass KI „kurzfristig“ mehr Nutzen als Verschwendung bringen würde, und fügte hinzu: „Deshalb denke ich nicht, dass wir aufhören sollten, sie zu entwickeln.“

Aussterben oder Unsterblichkeit

Der britische Physiker Stephen Hawking warnte deutlich.

Der britische Physiker Stephen Hawking sagte, dass „superintelligente KI das Ende der Menschheit herbeiführen könnte“.

„Eine vollständige KI-Entwicklung könnte das Ende der Menschheit bedeuten“, sagte Hawking 2014, vier Jahre vor seinem Tod, der BBC.

Hawking erklärte, dass eine Maschine mit diesem Intelligenzniveau nach und nach selbstständig arbeiten und sich selbst neu gestalten werde.

Nanobots und Unsterblichkeit

Einer der größten Fans von KI ist der Erfinder und Autor Ray Kurzweil, KI-Forscher bei Google und Mitbegründer der Singularity University im Silicon Valley.

Kurzweil glaubt, dass Menschen eine brillant intelligente KI nutzen werden, um biologische Barrieren zu umgehen.

Kurzweil behauptete 2015, dass wir bis 2030 Unsterblichkeit erreichen würden, dank Nanobots (sehr kleine Roboter), die im menschlichen Körper arbeiten und alle Krankheiten oder Schäden behandeln.

KI-Management

Guitérrez stimmt auch zu, dass die Einrichtung eines KI-Managementsystems am wertvollsten ist.

„Stellen Sie sich eine Zukunft vor, in der ein Wesen, das so viel über jeden auf dem Planeten weiß und seine Gewohnheiten kennt (durch Internetrecherchen), uns in einer Weise kontrollieren kann, die wir nicht einmal bemerken“, sagt er.

„Das schlimmste Szenario wäre kein Mensch-Roboter-Krieg. Das schlimmste wäre, nicht zu erkennen, dass wir manipuliert wurden, weil wir den Planeten mit einem Wesen teilen, das schlauer ist als wir.“

Mitwirkende Andrew Webb und Chris Vallance

T24